엔비디아, 내년 2분기 'HBM3E' 탑재 'H200' 출시 예정

AI 칩 성장세로 국내 메모리 업계 실적 개선에도 가속도

삼성·SK하닉, AI 반도체 수요 맞춰 양산 총력 대응 나서

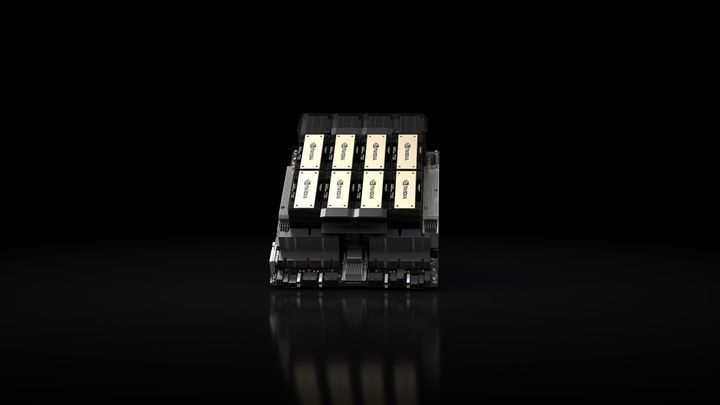

인공지능(AI) 반도체 팹리스(설계 전문기업) 미국 엔비디아가 기존 모델보다 데이터 처리 성능이 2배가량 향상된 최신 AI 칩을 내년 2분기에 내놓는다.

이 칩에는 차세대 고대역폭메모리인 ‘HBM3E’ 제품이 처음 탑재된다. HBM은 메모리 시장 판도를 바꿀 ‘게임 체인저’로 꼽힌다. 내년에는 특히 차세대 제품 양산으로 삼성전자와 SK하이닉스의 실적 개선에 가속도가 붙을 전망이다.

◆치솟는 AI 반도체 몸값…HBM도 부르는 게 값

15일 업계에 따르면 엔비디아가 최근 공개한 그래픽처리장치(GPU) ‘H200’는 현재 전 세계 기업들이 AI용 가속기로 사용하며, 제품 확보에 주력하는 ‘H100’을 업그레이드한 제품이다.

H200 가격은 아직 알려지지 않았지만, 현재 H100 칩 1개당 가격이 2만5000~4만달러라는 점을 고려할 때 H200 칩 가격은 이보다 훨씬 높을 것으로 예상된다.

여기에 들어가는 차세대 HBM 역시 기존 모델 대비 수익성이 더 클 전망이다. AI 개발 경쟁이 가속화 하면서, AI용 반도체 뿐 아니라 HBM도 함께 몸값이 치솟고 있다.

엔비디아 GPU의 경우 리드타임(주문에서 인도까지 걸리는 시간) 52주에 달하는 것으로 알려졌다. 엔비디아는 시장 지배력을 굳히기 위해 신제품 출시 주기를 기존 2년에서 1년으로 단축했다. 최근 엔비디아가 공개한 데이터센터용 GPU 제품 로드맵에 따르면 내년 ‘H100’ GPU를 잇는 차세대 ‘B100’가 나오며, 2025년 ‘X100’이 예정돼 있다.

반도체 업계가 차세대 제품 양산을 놓고 치열한 경쟁을 벌이는 것도 AI 시장이 비싼 값을 치를 수 있는 고부가가치 산업이기 때문이다. 업계에 따르면 올해 전체 D램 물량에서 HBM이 차지하는 비중은 3% 수준에 불과하다. 하지만 매출액은 9%에 달한다. 이어 내년에는 D램 매출의 12% 수준으로까지 늘어날 전망이다.

◆삼성·SK하닉, HBM 시장 경쟁 본격화

AI 반도체는 불확실한 경제 전망 속에서도 낙관론이 커지고 있다. 시장조사업체 IDC는 앞으로 AI 서버 업그레이드 등으로 생기는 반도체 매출이 2026년 2000억달러로, 반도체 전체 시장에서 상당 비중을 차지할 것으로 예측된다. 이는 올해 반도체 전체 시장 매출인 5265억달러의 37% 수준이다.

차세대 제품 양산을 준비하는 메모리 업체들의 각오도 남다르다.

내년에 열리는 HBM3E 시장에서도 SK하이닉스가 주요 공급사 지위를 차지할 수 있다. SK하이닉스는 주력 제품인 HBM3를 지난 2021년 세계 최초로 개발하는데 성공했고, 현재도 주요 고객사에 단독으로 제품을 납품하며 시장을 독점해왔다.

박명수 SK하이닉스 부사장은 지난달 열린 실적 발표 콘퍼런스콜에서 “HBM 등 D램 수요 강세로 서버향 제품 판매가 크게 증가하며 출하량이 전 분기 대비 20% 늘었다”며 “HBM3뿐 아니라 HBM3E까지 내년도 생산능력이 현시점에 이미 솔드아웃됐다”고 밝혔다.

김재준 삼성전자 부사장도 3분기 콘콜을 통해 “생성형 AI 수요가 급증하는 가운데 HBM3와 HBM3E 생산을 확대하고 있다”며 “내년 HBM 공급 역량은 올해 대비 2.5배 이상 확보할 계획”이라고 강조했다.

[서울=뉴시스]

4차 산업혁명 시대 >

구독

-

- 좋아요

- 0개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

-

- 추천해요

- 개

댓글 0