대화형 챗봇은 옛말… 사람처럼 보고 듣고 말하는 AI시대 성큼

- 동아일보

공유하기

글자크기 설정

구글 ‘제미나이’ 공개… GPT4와 경쟁

차트 요청하면 그래프 그리고 설명… 문제 보고 풀이, 오답 여부도 알려줘

구글 “인간 전문가 점수 뛰어넘어”

촉각 결합한 로봇 AI 연구도 활발

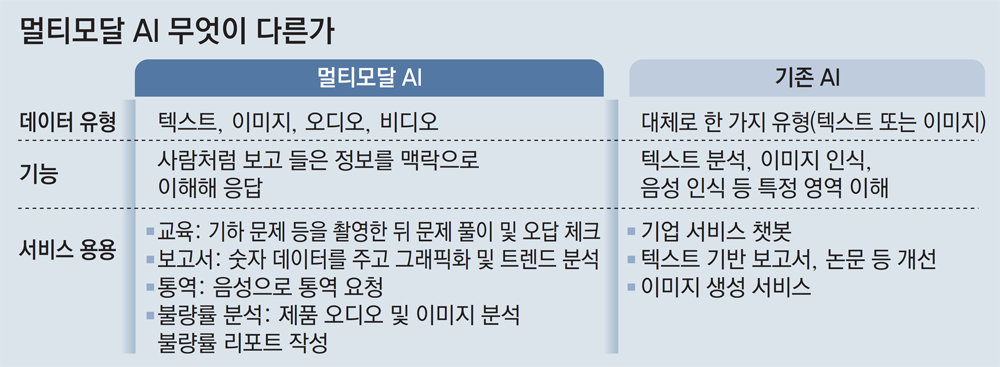

텍스트를 기반으로 한 대화형 챗봇 인공지능(AI) 경쟁이 사람처럼 보고 듣고 말하는 멀티모달(multi-modal) AI로 옮겨가고 있다. 오픈AI가 올 10월 보고 듣는 기능을 통합한 챗GPT(GPT-4)를 선보인 데 이어 구글도 6일(현지 시간) 멀티모달 AI ‘제미나이(Gemini)’를 공개했다. 구글은 제미나이 최상위 버전이 GPT-4를 능가했다고 밝혔다.

● 보고 듣는 멀티모달 AI 시대

챗GPT가 월 20달러 유료 고객에게 멀티모달 기능을 선보이자 반응은 열광적이었다. 기자가 ‘최근 90일 동안 미국 10년 만기 국채 금리 종가’가 담긴 엑셀 파일을 주고 차트로 만들라고 하자 선그래프를 그려주며 설명도 덧붙였다. 초등학교 저학년 수준 문제 사진을 찍어 ‘답이 맞는지 봐 달라’고 하면 문제 풀이와 함께 오답 여부를 알려줬다. 한국어로 말한 뒤 영어로 바꿔 달라고 하면 바로 통역도 해줬다.

구글이 이날 공개한 사전 녹화 영상에서 제미나이는 수학 시험지를 보여주면 오답을 분석하고, 물리 시험도 그림을 보고 척척 풀었다. GPT-4를 노리고 만든 최상위 버전 제미나이 울트라는 대규모 다중작업 언어 이해(MMLU) 테스트 정답률이 약 90% 수준이었다. GPT-4는 86.4%를 기록했다. MMLU는 수학 물리학 역사 법률 의학 윤리 등 57개 주제를 복합적으로 활용해 AI 지식과 문제 해결 능력을 평가하는 테스트다. 구글 측은 “인간 전문가 점수인 89.8%를 넘은 최초의 모델”이라고 강조했다. 제미나이 울트라는 내년 출시 예정이어서 아직 일반 대중이 검증할 수는 없다. 챗GPT 무료 버전인 GPT-3.5의 대항마 제미나이 프로는 이날 구글 챗봇 ‘바드’에 바로 적용됐다.

● 후각, 촉각도? “다음은 로봇 AI”

AI 경쟁이 멀티모달 AI로 진화하는 것은 이미지와 비디오, 오디오 등 반응 데이터 종류가 확장될수록 AI를 적용할 수 있는 범위도 넓어지기 때문이다. 기업에서는 멀티모달 AI를 활용해 불량품을 잡아낼 수도 있다. 텍스트나 이미지만으로 판단하고 응답하는 AI에 비해 활용도가 높아져 통·번역, 교육, 서비스 등 기업들도 관심을 갖고 있다.

가까운 미래에는 여기에 로봇 공학까지 결합해 사람에 더 가까워진 AI로 진화할 것이라는 전망이 나온다. 허사비스 CEO는 이날 “진정한 멀티모달이 되려면 촉각 피드백을 포함해야 한다”면서 보고 듣는 것 외에 만져서 받아들이는 정보도 파악해 추론 데이터로 활용하는 로봇 AI를 연구하고 있다고 밝혔다.

4차 산업혁명 시대 >

구독

© dongA.com All rights reserved. 무단 전재, 재배포 및 AI학습 이용 금지

트렌드뉴스

-

1

트럼프, 결국 ‘대리 지상전’…쿠르드 반군 “美요청에 이란 공격”

-

2

美국방차관 “한국이 北 상대 재래식 대응 책임지기로 합의”

-

3

트럼프, 기지 사용 거부 스페인에 “모든 교역 중단”

-

4

트럼프 안 겁내는 스페인…공습 협조 거부하고 무역 협박도 무시

-

5

세계 최초 이란 ‘드론 항모’, 알고보니 한국산?

-

6

병걸리자 부모가 산에 버린 딸, ‘연 500억 매출’ 오너 됐다

-

7

李 “주유소 휘발유 값 폭등…돈이 마귀라지만 너무 심해”

-

8

배우 이상아 애견카페에 경찰 출동…“법 개정에 예견된 일”

-

9

이스라엘 “F-35 아디르 전투기로 이란 YAK-130 격추”

-

10

결혼은 하겠지만 결혼식은 않기로

-

1

[김순덕 칼럼]‘삼권장악 대통령’으로 역사에 기록될 텐가

-

2

‘증시 패닉’ 어제보다 더했다…코스피 12%, 코스닥 14% 폭락

-

3

[단독]한미, 주한미군 무기 중동으로 차출 협의

-

4

“美, 하메네이처럼 김정은 제거 어렵다…北, 한국에 핵무기 쏠 위험”

-

5

李 “주유소 휘발유 값 폭등…돈이 마귀라지만 너무 심해”

-

6

주가 폭락에…코스피·코스닥 서킷브레이커 발동

-

7

트럼프, 결국 ‘대리 지상전’…쿠르드 반군 “美요청에 이란 공격”

-

8

與 “조희대 탄핵안 마련”… 정청래는 “사법 저항 우두머리냐”

-

9

李 “필리핀 대통령에 수감된 한국인 마약왕 인도 요청”

-

10

국힘 또 ‘징계 정치’… 한동훈과 대구行 8명 윤리위 제소

트렌드뉴스

-

1

트럼프, 결국 ‘대리 지상전’…쿠르드 반군 “美요청에 이란 공격”

-

2

美국방차관 “한국이 北 상대 재래식 대응 책임지기로 합의”

-

3

트럼프, 기지 사용 거부 스페인에 “모든 교역 중단”

-

4

트럼프 안 겁내는 스페인…공습 협조 거부하고 무역 협박도 무시

-

5

세계 최초 이란 ‘드론 항모’, 알고보니 한국산?

-

6

병걸리자 부모가 산에 버린 딸, ‘연 500억 매출’ 오너 됐다

-

7

李 “주유소 휘발유 값 폭등…돈이 마귀라지만 너무 심해”

-

8

배우 이상아 애견카페에 경찰 출동…“법 개정에 예견된 일”

-

9

이스라엘 “F-35 아디르 전투기로 이란 YAK-130 격추”

-

10

결혼은 하겠지만 결혼식은 않기로

-

1

[김순덕 칼럼]‘삼권장악 대통령’으로 역사에 기록될 텐가

-

2

‘증시 패닉’ 어제보다 더했다…코스피 12%, 코스닥 14% 폭락

-

3

[단독]한미, 주한미군 무기 중동으로 차출 협의

-

4

“美, 하메네이처럼 김정은 제거 어렵다…北, 한국에 핵무기 쏠 위험”

-

5

李 “주유소 휘발유 값 폭등…돈이 마귀라지만 너무 심해”

-

6

주가 폭락에…코스피·코스닥 서킷브레이커 발동

-

7

트럼프, 결국 ‘대리 지상전’…쿠르드 반군 “美요청에 이란 공격”

-

8

與 “조희대 탄핵안 마련”… 정청래는 “사법 저항 우두머리냐”

-

9

李 “필리핀 대통령에 수감된 한국인 마약왕 인도 요청”

-

10

국힘 또 ‘징계 정치’… 한동훈과 대구行 8명 윤리위 제소

-

- 좋아요

- 0개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

댓글 0