※ 하이프 사이클: 기술의 성숙 정도를 나타내는 주기를 시각적으로 표현한 개념. 2000년대 중반 가트너에서 만든 것으로, 기술 촉발 - 부풀려진 기대의 정점 - 환멸의 계곡 - 계몽의 슬로프 - 생산성 안정의 다섯 단계로 구성돼 있다.

2023년 오픈AI와 미국 펜실베이니아대학의 공동 연구에서 기자는 대형 언어 모델(LLM)을 통해 업무의 50% 이상을 줄일 수 있는 환경에 노출될 가능성이 100%에 달하는 대표적인 직업으로 꼽혔다. 저널리즘이 생성형 AI의 영향에서 벗어나기 어렵다는 뜻이다.그렇다면 언론사와 언론인은 생성형 AI를 어떻게 활용해야 할까. 지난달 24일(현지 시간) 영국 런던의 런던정경대(LSE)에서 기자 출신인 찰리 배켓 교수에게 “생성형 AI 시대에 저널리스트의 역할은 무엇이라고 보느냐”고 물었다. 배켓 교수는 “인간이라는 그 자체”라고 답했다. 일상적인 업무가 자동화되는 시기에는 호기심, 연민, 유머 감각 같은 인간 고유의 특성이 더욱 중요해질 것이라는 설명이었다.

“Gen AI는 유능한 조수일 뿐, 핵심은 기자 개인”

배켓 교수는 BBC와 채널4 뉴스 등에서 20년 이상 기자, 프로듀서 등으로 일했다. 2006년 런던정경대(LSE) 내 저널리즘 싱크탱크인 ‘폴리스(Polis)’를 만들었고, 2019년부터는 뉴스 조직이 AI를 책임감 있게 사용할 수 있게 지원하는 글로벌 이니셔티브 ‘저널리즘AI’ 프로젝트를 이끌고 있다. 그는 생성형 AI의 역할에 대해 단호히 선을 그었다. “기자들은 생성형 AI를 유능한 조수 정도로 생각하는 것이 가장 좋을 것”이라고 했다. 비서나 인턴처럼 필요한 도움을 주는 존재일 뿐, 그 이상의 역할을 기대해서도 안 되며 의존해서는 더욱 안 된다는 것이다. 그는 “모든 결정을 내려야 하는 것은 기자”라며 “생성형 AI가 보조적인 역할을 할 순 있지만, 궁극적으로 기자와 독자의 인간적인 관계 형성이 핵심이 될 것”이라고 말했다.

생성형 AI로 인해 고도로 발달된 허위 정보가 확산할 것이라는 우려에 대해서도 인간의 역할을 강조했다. 그는 “생성형 AI가 아침에 일어나서 ‘아 오늘은 가짜 뉴스를 만들어야겠다’라고 생각하지 않는다”고 말했다. AI와 기술이 정치적 허위 정보를 만드는 데 도움을 줄 순 있겠지만, 실제로 그 허위 정보를 만들라고 지시하는 것은 인간이라는 것이다.

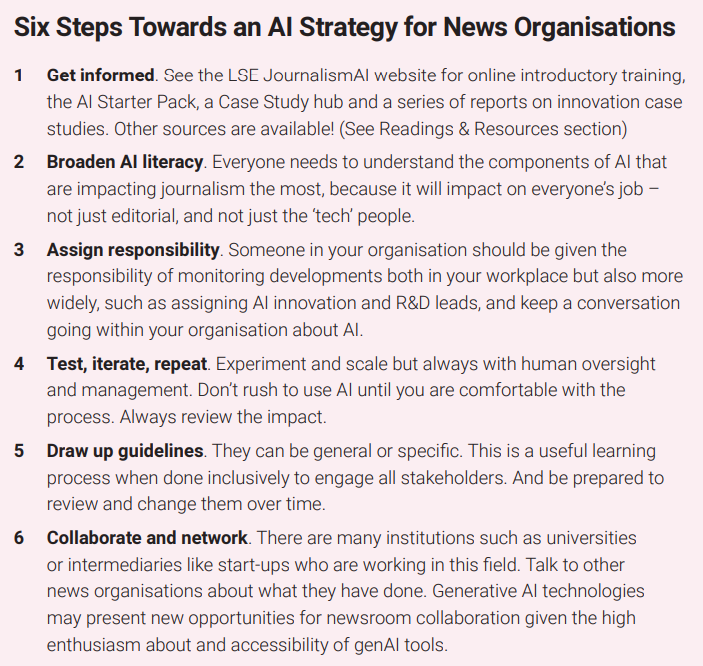

언론사에는 ‘6단계 전략’ 권해

배켓 교수를 비롯한 연구진은 지난해 내놓은 ‘변화의 생성(generating change)’라는 연구 보고서에서 뉴스 조직을 위한 ‘AI 전략 수립을 위한 여섯 단계’를 제안한 바 있다. ‘정보 습득’ ‘AI 이해력 확대’ ‘책임 부여’ ‘테스트, 반복, 검토’ ‘가이드라인 작성’ ‘협력 및 네트워킹’이다. 특히 ‘테스트, 반복, 검토’와 ‘가이드라인 작성’ 단계를 길게 설명했다.배켓 교수는 “(생성형 AI) 도구를 사용하면서 실험해 봐야 한다. 제대로 작동하지 않는다면 사용하지 말아야 한다. 잘 작동한다면 계속 사용하면 된다. 그런 식으로 반복하면서 어떤 것이 작동하는지 지켜봐야 한다”고 말했다. 이어 “문제가 생겼을 때 대처하는 매뉴얼처럼 AI에도 가이드라인이 필요하다. 기자들에게도 유용하지만, 무엇보다 독자들에게 도움이 되기 때문”이라고 설명했다.

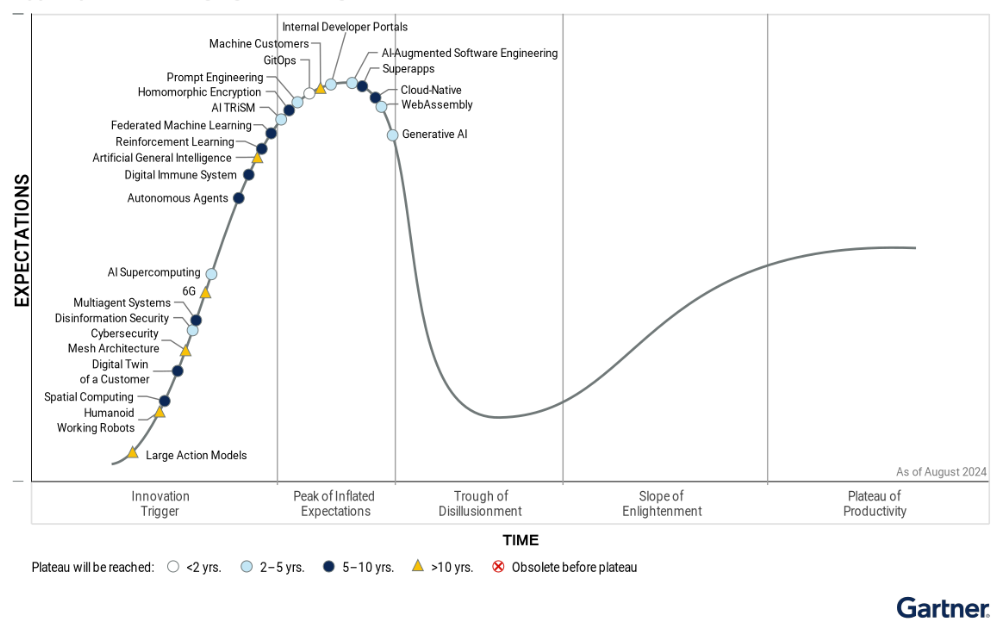

가트너의 전망처럼 생성형 AI를 둘러싼 논의가 위험·안전·규제 등의 단계로 넘어가기 시작하는 상황에서, 배켓 교수는 저널리즘 분야에 있어서는 정부의 직접적 규제보다는 거버넌스 수준의 합의가 적절하다고 봤다. 그는 “언론인들이 스스로 책임의 범위를 정립하는 것이 중요하다”며 “가이드라인을 마련하고, AI 활용 현황에 대해 투명하게 공개해야 한다”고 말했다.

생성형 AI가 미래에 미칠 영향을 단순하게 평가해서는 안 된다고 경고하는 것도 잊지 않았다. 웹 기술이 20년간 이어온 변화를 생성형 AI는 2년 만에 이뤄냈기 때문에 변화의 속도나 범위도 예상하기 어렵다고 했다. 배켓 교수는 “사람들은 기술 변화의 단기적 영향을 과장하는 경향이 있지만, 장기적으로 미칠 영향을 간과하는 실수도 한다”고 지적했다.

※ 이 기사는 한국언론진흥재단 주최 KPF 디플로마-AI저널리즘 과정의 일환으로 작성되었습니다.

’

-

- 좋아요

- 0개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

댓글 0