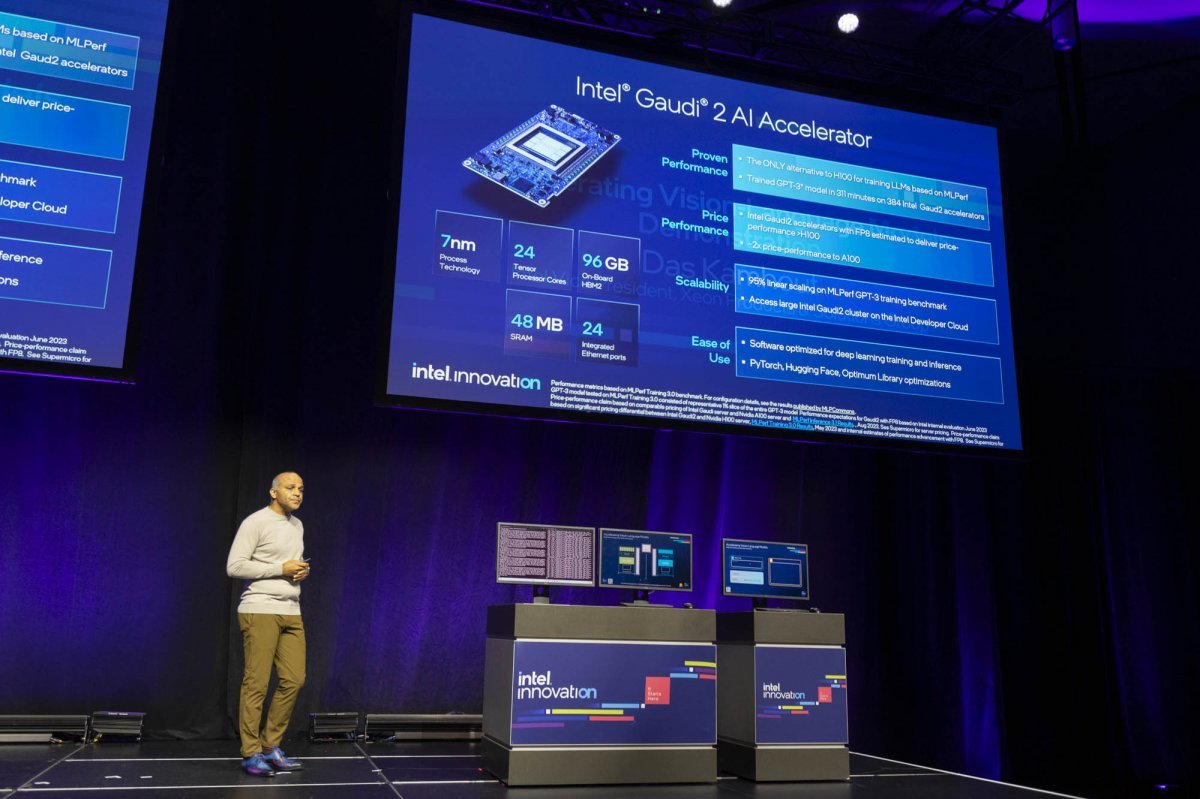

특히나 최근 주목받고 있는 AI에 대해서도 대응하고 있다. 인텔은 현재 7nm 공정 기반의 가우디 2 AI 가속기를 시장에 선보이고 있으며, 4세대 제온 프로세서와 4천 개의 가우디 2를 조합한 초대형 슈퍼 컴퓨터도 구축한 상황이다. 해당 컴퓨터가 스테이블 디퓨전의 슈퍼 컴퓨터로 제공되면서 가우디 2의 자세한 성능 및 구성에도 시선이 쏠리는 상황이다. 이에 디팩 파틸(Deepek Patil) 인텔 데이터센터 AI 솔루션 부사장이 인텔의 AI 전략 및 가우디 2 시연에 나섰다.

네 단계로 구분되는 인텔의 AI 전략

디팩 파틸은 “인텔은 모든 기기와 모든 사람, 그리고 기존의 통념과 다른 모든 사례에 AI를 도입하고자 한다. 특히 10년 사이에 기계 학습은 빠르게 진화했고 AI의 수준도 높아졌다. 교육에서 에너지, 헬스케어 등 사회 전반에서 혁신이 일어나고 있으며, 우리 주변 어디서든 놀라운 일들이 발생하고 있다”라고 말했다. 하지만 “AI 모델의 매개변수가 1만5000배 증가하면서 비용은 크게 상승했다. GPT3만 해도 16억 5천만 달러(한화 약 2조 1920억 원)가 소요됐고, 추론 비용도 계속 들어가고 있다”라고 말했다. 단순히 성능만 끌어올리는 것을 넘어서 AI를 효율적으로 다룰 필요성이 제기되는 것이다.

이에 인텔은 네 가지 방식의 AI 구분 방법을 제안한다. 우선 AI는 규모에 따라 구분할 수 있다. 또 훈련(Training) 및 파인 튜닝(Fine-Turning)부터 추론(Inference) 및 전개(Deployment), 클라우드인지 클라이언트인지, 특정 목적 용도인지 다용도 목적인지로 나뉜다.

모델의 크기는 AI의 활용도부터 성능을 구분 짓는 핵심 요소다. 모델의 크기가 커지면 방정식 처리, 콘텐츠 및 데이터 처리, 심지어는 코드 작성까지 가능하지만, 보다 일상적인 영역에서는 작은 모델이 더욱 가치를 발휘한다. 작은 크기의 모델은 얼굴 및 음성 인식이나 사물 인식, 자율주행, 군중 밀집도, 보안, 의료 이미지 등이 해당된다.

훈련 및 파인 튜닝은 AI를 개발할 때 쓰이는 심화 학습(딥러닝), 그리고 이를 미세 조정하는 파인 튜닝이 한 축을 담당하고, 이미 만들어진 모델을 기반으로 데이터를 예측해서 수행하는 추론 및 전개 등으로 구분한다. 인텔은 AI 개발 흐름이 개방형인지, 생산성인지, 접근성을 우선시하는지를 두고 제품을 구분하기로 했다.

인텔 가우디 2 AI 가속기, AI 시장에 적절한 대안

네 단계에 따른 AI 구분에서 현재 가장 범용적이고 널리 쓰이는 제품은 엔비디아의 H100 그래픽 카드다. H100은 성능 면에서 가장 우수한 편에 속하면서도, GPU 특유의 범용성으로 다양한 조건의 AI에서 활용할 수 있다. 다만 품귀현상이 지속되면서 가격이 가파르게 상승하는 등의 문제가 있다. 인텔은 그에 대한 대안으로 가우디 2 AI 가속기를 추천한다.

가우디 2 AI 가속기는 7나노미터 기반의 공정으로 제조됐으며, 24개의 텐서 코어와 96GB HBM2 메모리를 탑재하고 있다. 또한 내부에 48MB의 SRAM이 적용됐다. GPT 등 대형 언어 모델에 대한 MLPerf 성능 비교에서 현재 유일하게 엔비디아 H100의 대안 수준의 성능을 갖추고 있으면서도, 가격은 하위 성능 모델인 A100 수준으로 경제적이다. 활용 측면에서도 파이토치, 허깅 페이스 등 대중적인 도구를 쓸 수 있다.

허깅 페이스를 기반으로 30억 개의 매개변수를 포함한 T5-3B 모델로 대형 언어모델을 미세 조정(Fine-Tuning) 한 결과 비교에서는 가우디 2가 엔비디아 A100 80GB에 비해 2.44배 빠르게 데이터를 처리한 것으로 나타난다. 가우디의 최신 비전 언어 모델인 브릿지 타워를 활용하면 A100에서는 2.5배, H100 80GB와 비교해서는 1.4배 빠른 것으로 확인된다.

AI용 벤치마크인 MLPerf의 추론 항목 중 오픈소스 기반의 GPT-J로 진행하는 테스트에서는 엔비디아 H100과 동등한 성능을 제공하고, 정밀도를 낮춰 효율성을 끌어올린 8비트 부동소수점(FP8)을 구동할 때에도 99.9%의 정확도를 달성할 정도다.

“진입장벽 낮추면 참여 늘어··· 더 많은 개발자 환영”

발표 말미에 산드라 리베라(Sandra Rivera) 인텔 데이터 센터 및 AI 그룹 부문 총괄 및 수석부사장은 “인텔은 AI 시장에 개방형 생태계를 구축하기 위해 모든 유형의 작업, 모든 유형의 배포 모델을 제공하기 위한 노력을 기울이고 있다”라면서, “많은 개발자들이 인텔의 개방형 여정에 협력해 주기를 기대하며, 어떻게 하면 더 효율적으로 서비스할 수 있을지 의견을 보내주었으면 한다. 모든 유형의 가격과 제약사항, 요구 사항을 맞추기 위해 노력하겠다”라고 덧붙였다.

동아닷컴 IT전문 남시현 기자 (sh@itdonga.com)

-

- 좋아요

- 0개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

![[사설]1기 신도시 재건축 ‘선도지구’ 선정… 이주·교통 대책이 관건](https://dimg.donga.com/a/464/260/95/1/wps/NEWS/FEED/Donga_Home_News/130522442.1.thumb.jpg)

댓글 0