애플뿐만 아니라 마이크로소프트도 생성형 AI 조수인 코파일럿을 워드, 엑셀, 파워포인트 등 마이크로소프트 365 제품군과 윈도우 운영체제에 통합하면서 좀 더 밀접한 서비스를 제공하는 추세인데요.

그런데 이렇게 생성형 AI가 개인화된 서비스를 제공하기 위해 민감한 개인 정보나 사생활이 담긴 데이터를 들여다본다는 게 꺼림찍한 분들도 계실 겁니다. 이런 AI 서비스의 이면에 AI 모델 학습을 위한 데이터를 수집하려는 빅테크들의 검은 속내가 담긴 건 아닐지 의심스럽다는 poiXXXX님의 질문입니다.

이용자 데이터는 답변 생성에만 활용

AI 서비스들이 개인화된 답변을 제공하기 위해서 이용자의 데이터를 활용하는 것 자체는 맞습니다. 가령 애플 인텔리전스와 결합된 시리는 이용자의 스마트폰에 저장된 통화 요약, 메시지, 이메일 등의 정보에 모두 접근할 수 있죠. 애플이 시연에서 보여준 것처럼 “엄마가 탄 비행기가 언제 도착하지?”라고 물으면, 시리가 이용자가 엄마랑 나눈 통화, 메시지, 이메일 등을 뒤져서 엄마가 언제 어느 항공편을 타는지 알아내서 답변을 합니다.

하지만 이렇게 AI 서비스가 이용자에게 유용한 답변을 내놓기 위해 민감한 이용자 데이터를 참고 하는 게 이를 활용해 모델을 학습시킨다는 걸 의미하지는 않습니다. 생성형 AI 서비스가 답변을 생성할 때 이용자 데이터를 맥락으로 참고해 답변을 생성하는 것과 AI 모델을 개발하거나 성능을 개선하기 위해 데이터를 입력해 학습시키는 건 별개의 과정이기 때문입니다.

우리가 생성형 AI로부터 도움을 받기 위해 프롬프트(명령어)를 입력하고 기기에 저장된 메시지, 이메일 등을 맥락으로 제공하는 게 진료 행위라면, 이런 데이터로 LLM을 학습시켜 성능을 개선하는 건 이를 가지고 논문을 쓰거나 학계에 발표하는 건 의학이라는 학계에 지식을 보태는 일이겠습니다.

환자들이 어디까지나 진료를 받기 위해 정보를 제공하는 거지, 그 외 용도로 마음대로 쓰길 원치 않는 것처럼 AI 서비스를 이용하는 사람들도 내 데이터를 기업들이 마음대로 가져다 모델 학습에 쓰는 걸 원치는 않을 겁니다. 이 때문에 빅테크들도 이용자들에 대한 고지나 동의를 받지 않고 마음대로 데이터를 수집해 모델 학습에 쓸 수는 없는 노릇입니다. 더군다나 최근에는 AI 학습 데이터 수집으로 인한 저작권, 개인정보 침해에 대한 우려가 커지면서 더욱더 조심하는 분위기가 번지고 있기도 하고요. 각국의 개인정보 보호 관련 법안 또한 이용자에게 고지나 동의 없이 마음대로 민감한 이용자 데이터를 쓰지 못하게 법적으로 막고 있습니다.

실제로 애플, 마이크로소프트 등 AI 서비스를 제공 중인 기업들도 이용자들의 개인 데이터를 거대언어모델(LLM) 학습에 사용하지는 않는다고 분명히 밝히고 있습니다. 가령 애플은 별도의 웹사이트 설명에서 “우리는 이용자의 고유한 개인 정보나 상호작용을 파운데이션 모델 학습에 사용하지 않는다”고 명시하고 있습니다.

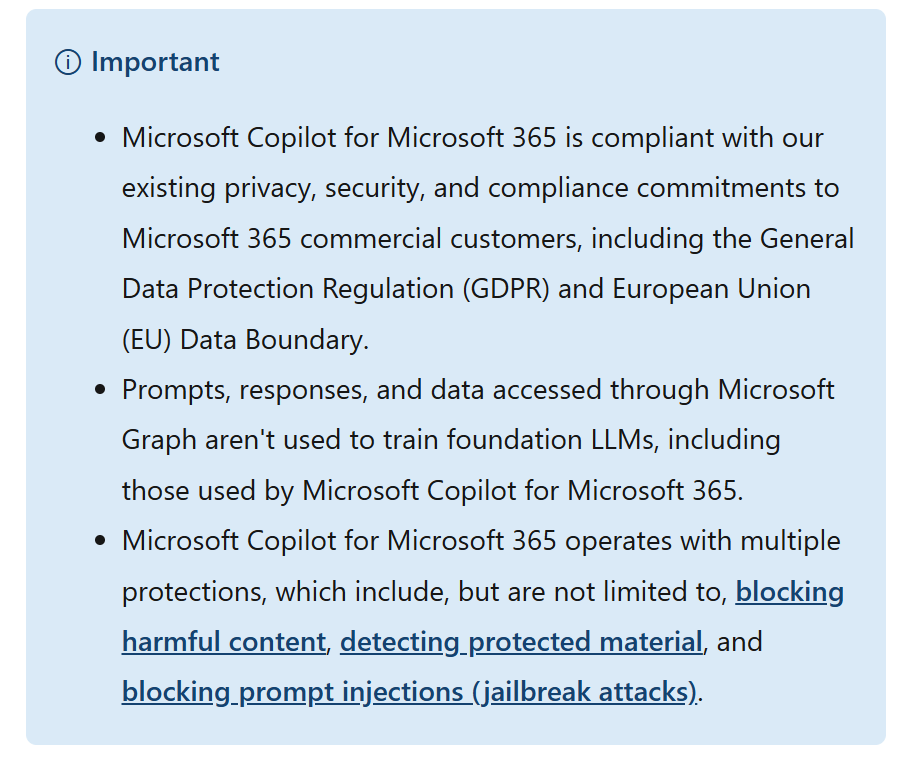

마이크로소프트도 마찬가지입니다. 현재 마이크로소프트가 마이크로소프트 365에서 제공하는 코파일럿은 ‘마이크로소프트 그래프’라는 툴을 통해 기업이나 개인이 저장해 둔 데이터를 답변 생성에 참고합니다. 하지만 이러한 데이터는 어디까지나 이용자의 요청에 가장 적합한 결과물을 맥락에 맞게 제공하기 위해 사용될 뿐, 모델 학습에는 사용하지 않는다고 밝혔습니다.

또한 시스템상으로도 이들이 개인정보를 들여다볼 수 없도록 하는 보안 조치를 취하고 있습니다. 애플의 예를 들자면, 애플 인텔리전스가 클라우드에서 AI를 처리할 때 모든 데이터는 ‘비공개 클라우드 컴퓨팅’이라는 서버를 통해 암호화되어 처리되며, 애플 또한 여기에 접근할 수 없다고 애플은 설명합니다. 이런 애플의 개인정보 보호 체계에 이상이 없는지 외부 전문가들이 검증할 수 있는 체계 또한 마련해 두었다고 하고요.

따라서 이 기업들의 공식적인 입장이나 약관, 개인정보 보호 정책을 믿는다면, 이들이 의도적으로 이용자 데이터를 수집해 AI 학습을 위한 공공재처럼 사용하는 상황을 걱정하지는 않아도 되겠습니다.

물론 아무리 기업들이 보호 체계를 갖춘다고 해도 세상에 완벽이라는 건 없는 법입니다. 생각지도 못한 시스템상의 허점이나 인간의 실수로 이러한 개인정보가 유출되는 불상사가 일어나기도 합니다. 가령 지난해 오픈AI가 챗GPT의 속도 증가를 위해 시스템을 손보던 중 오류가 발생하며 일부 이용자 정보가 유출되는 일이 있었죠. 결국 이런 AI 서비스를 이용하면 그렇지 않을 때보다는 개인정보 유출 위험이 증가하는 건 분명한 사실이라고 할 수 있습니다.

'IT애정남'은 IT제품이나 서비스의 선택, 혹은 이용 과정에서 고민을 하고 있는 독자님들에게 직접적인 도움이 되고자 합니다. PC, 스마트폰, 카메라, AV기기, 액세서리, 애플리케이션 등 어떤 분야라도 '애정'을 가지고 맞춤형 상담을 제공함과 동시에 이를 기사화하여 모든 독자들과 노하우를 공유할 예정입니다. 도움을 원하시는 분은 mh@itdonga.com으로 메일을 보내 주시기 바랍니다. 사연이 채택되면 답장을 드리도록 하겠습니다.

IT동아 권택경 기자 tk@itdonga.com

-

- 좋아요

- 0개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

![[김도연 칼럼]정치인이 잠든 밤에 대한민국은 발전한다](https://dimg.donga.com/a/464/260/95/1/wps/NEWS/FEED/Donga_Home_News/130725012.1.thumb.png)

![[횡설수설/이진영]무모한 ‘계엄 망상’ 언제 싹 텄을까](https://dimg.donga.com/a/464/260/95/1/wps/NEWS/FEED/Donga_Home_News/130724326.2.thumb.jpg)

댓글 0