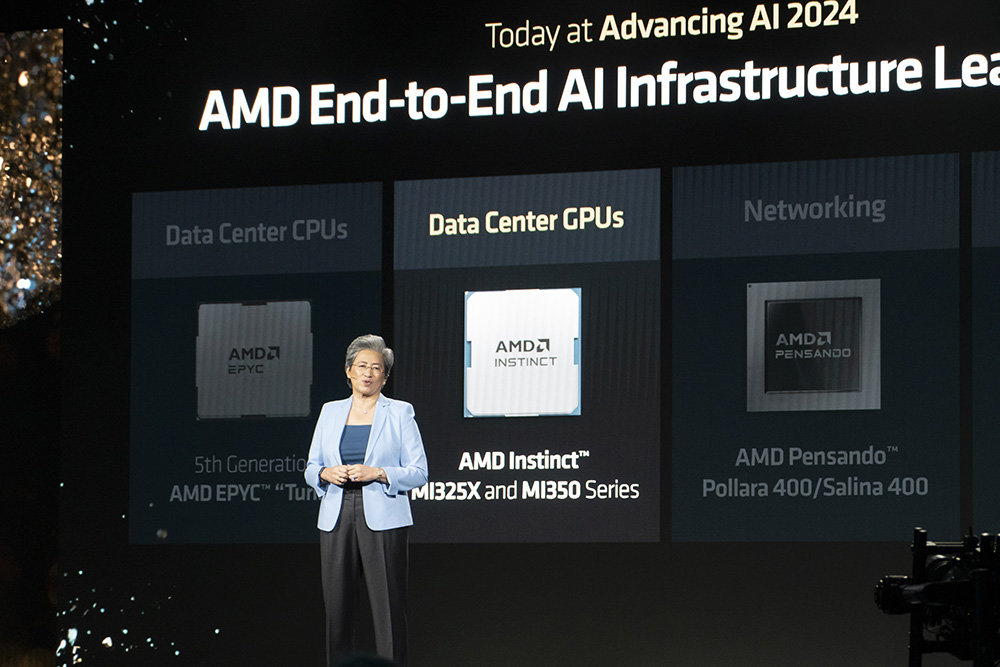

글로벌 반도체 설계 기업 AMD가 현지시간으로 10월 10일, 미국 캘리포니아주 샌프란시스코 모스콘 센터에서 ‘어드밴싱 AI’ 행사를 열고 새로운 인스팅트 AI 가속기 및 서버용 에픽 프로세서, 네트워킹 장비, 기업용 프로세서 등을 공개했다. 이번에 출시된 AMD 인스팅트 MI325 AI 가속기는 인스팅트 MI300의 후속으로, 256GB의 HBM3E 메모리로 엔비디아 H200과 경쟁한다.

5세대 에픽(EPYC) 프로세서는 앞서 대만 컴퓨텍스 2024에서 주요 정보가 사전에 공개된 바 있으며, 이번 행사를 통해 공식 출시하고 올 하반기 판매를 시작한다. AMD의 기업용 제품군인 라이젠 프로 AI 300 프로세서 제품군, 데이터센터용 AMD 펜산도 폴라라 400 네트워킹 인터페이스 카드, 펜산도 셀리나 400 데이터 처리 장치(DPU)도 함께 공개됐다.

AMD MI325X AI 가속기 출시, 엔비디아 H200과 경쟁

AMD는 지난해 12월, 데이터서버용 AI 가속기인 인스팅트 MI300 시리즈를 공식 출시했다. 이후 5월부터 제품 인도가 시작됐고, 현재 마이크로소프트, 오픈AI, 메타에서 활용 중이며, 코히어, 스태빌리티AI, 에센셜AI를 비롯한 25개 주요 파트너사에서 운용 중이다.

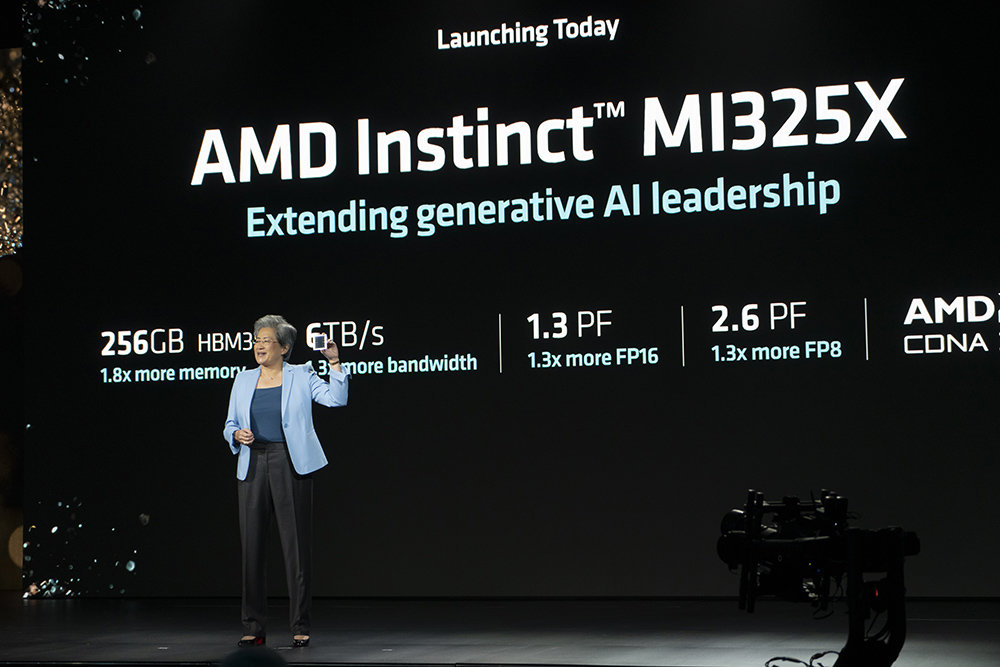

이번에 출시되는 인스팅트 MI325X는 고성능 버전인 MI300X의 후속으로, 전작의 192GB HBM3에서 더 상향된 256GB HBM3E 메모리를 갖추며, 메모리 대역폭도 초당 5.3TB에서 6TB로 늘었다. 8개를 연결한 구성에서는 초당 896GB의 인피티니 패브릭 대역폭으로 연결되며, 2TB의 HBM3E 메모리와 48TB의 대역폭을 갖춘다. 성능은 FP8 기준 20.8PF(페타플롭스), FP16 기준 10.4PF를 제공한다.

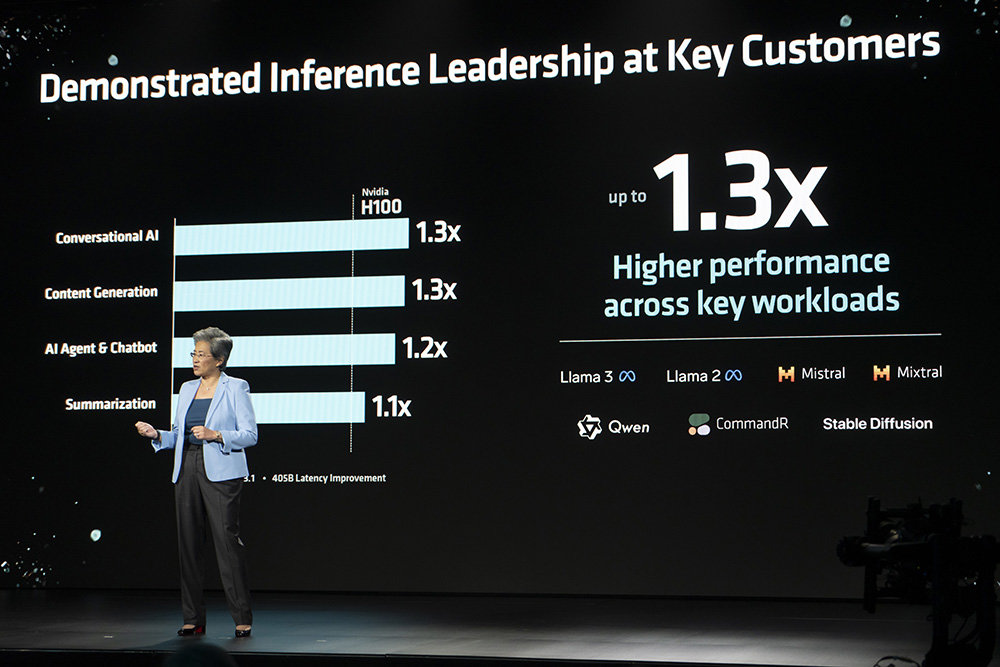

엔비디아의 고성능 AI 가속기인 H200과 비교해도 1.3배 높은 FP16 및 FP8 성능과 1.8배 높은 메모리 용량, 1.3배 높은 메모리 대역폭을 갖춘다. 추론 성능은 H200 HGX 시스템과 비교해 라마 3.1 405B 모델을 1.4배 더 빨리 처리하며, 라마 3.1 70B 모델은 1.2배 빨리 처리한다. 훈련 기능도 크게 강화돼 엔비디아 H200과 인스팅트 MI325X를 단일 비교했을 때 라마 2 7B 모델을 1.1배, 8개 구성에서는 라마 2 70B 모델과 동등한 처리 성능을 제공한다.

2025년 출시 예정인 인스팅트 MI350 시리즈도 첫선

아울러 2025년 출시 예정인 차세대 제품인 인스팅트 MI350 시리즈에 대한 주요 정보도 공개됐다. MI350 시리즈는 3nm 공정 기반에 CDNA4 아키텍처를 활용하며, 288GB의 HBM3E 메모리와 FP4 및 FP6 처리를 새롭게 지원한다. 8대를 구성한 구성에서는 최대 2.3TB의 HBM3E 메모리와 64TB의 메모리 대역폭을 갖추며, 이를 통해 18.5PF(페타플롭스)의 FP16, 37P FP8, 새로 지원하는 FP6 및 FP4도 각각 74PF의 처리 성능을 지원한다.

세부 모델인 인스팅트 MI355X는 MI325X와 비교해 1.8배 빠른 FP16, FP8 처리 성능을 제공한다. 3세대 이전 제품인 MI300과 비교하면 7.4배 향상된 AI 플롭스 처리 성능, 처리 가능한 모델 크기는 6배나 커졌다. AMD는 올해 4분기 중 인스팅트 MI325X 생산을 시작하고, 내년 1분기 중 델 테크놀로지스, 에비덴, 기가바이트, HPE 등 주요 파트너사에서 판매를 시작한다. AMD는 2025년 중 MI350을 출시하고, 26년에는 MI400 시리즈를 낼 예정이다.

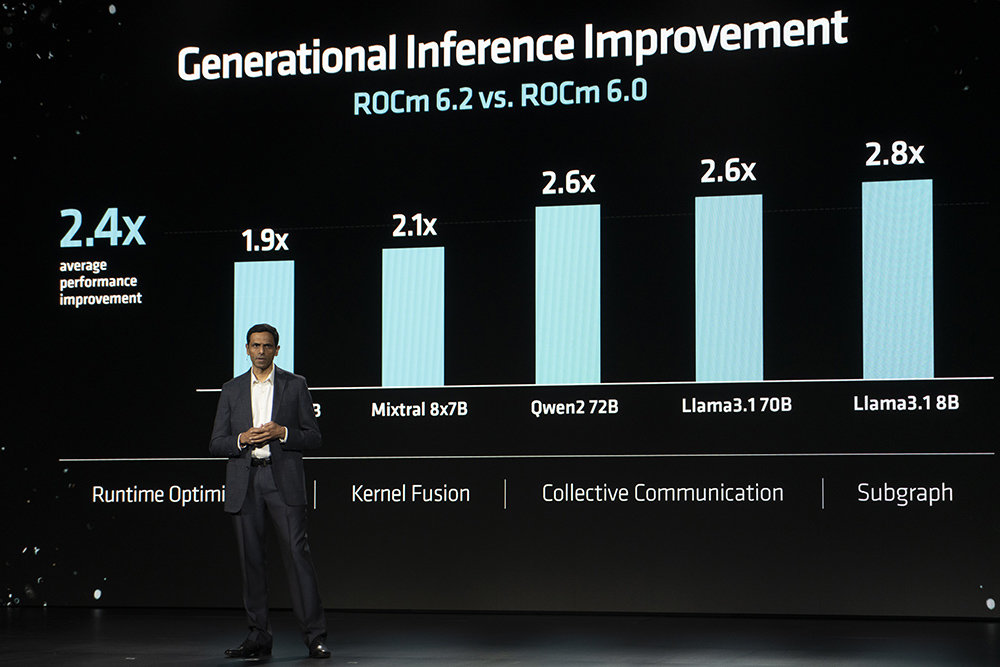

한편 AMD 개발 생태계를 확대하기 위한 ROCm 관련 소식도 덧붙였다. AMD ROCm 6.2 버전은 6.0과 비교해 LLM 처리 성능을 최소 1.9배에서 2.8배까지 끌어올렸고, 훈련 성능 역시 평균 1.8배 향상됐다. AMD는 ROCm 호환성 향상을 위해 올해 7월 인수한 AI 스타트업 사일로AI를 투입한다. AMD 사일로 AI 조직은 약 200여 개의 유럽 언어 기반 LLM 작업을 수행한 바 있다.

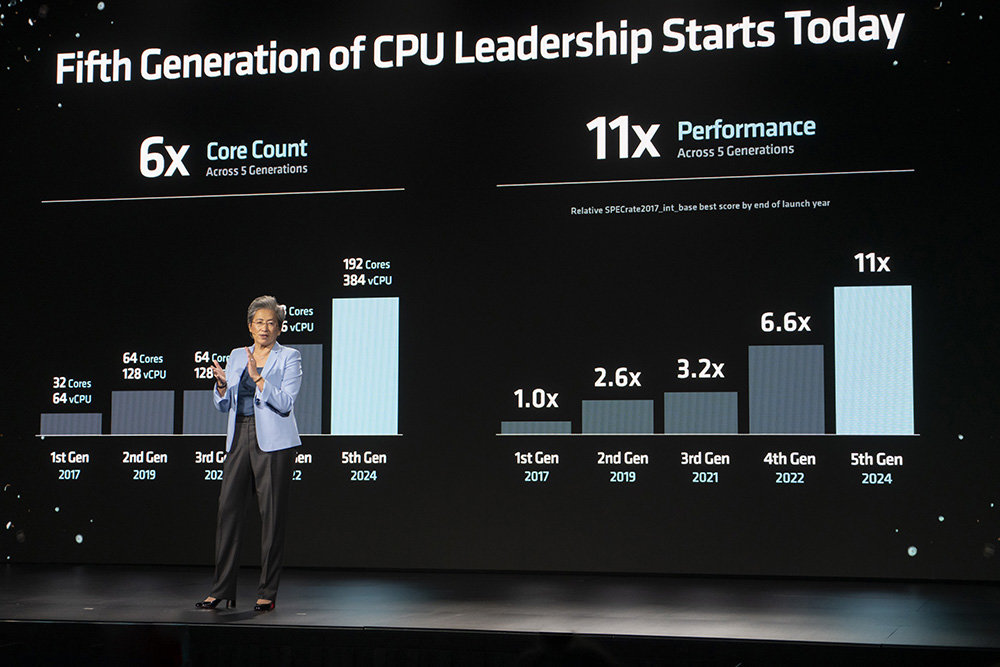

5세대 에픽 최대 192코어 384스레드··· 서버 점유율 30% 노린다

AMD는 4세대 에픽 프로세서를 통해 시장 점유율을 27%까지 끌어올렸으며, 현재 350개의 OEM 플랫폼과 950여 개의 클라우드 인스턴스로 제공된다. AMD는 5세대 에픽 프로세서를 통해 30% 이상 점유율 확보를 목표로 하며, 서버 CPU 시장 주도와 전력 효율성 확보, AI 기능 강화를 핵심 목표로 설정했다.

프로세서는 3/4나노미터 젠5, 젠5C 아키텍처가 혼용된다. 젠5 아키텍처는 최대 128코어 256스레드까지 있고, 젠5C 아키텍처가 최대 192코어 384스레드로 구성된다. SP5 소켓은 그대로 유지되며, 5GHz의 동작 속도와 AVX-512 명령어를 512b 데이터 패스를 최대 지원한다. 소비전력은 최소 8코어 155W에서 최대 192코어 500W로 설정된다. 메모리는 12채널 DDR5-6400을 지원하고, 소켓당 최대 6TB의 메모리를 인식한다. PCIe 5.0는 128레인에 암호화를 지원하고, CXL 2.0 규격 저장장치도 호환된다. 보안 측면에서는 트러스티드 I/O를 처음 지원한다.

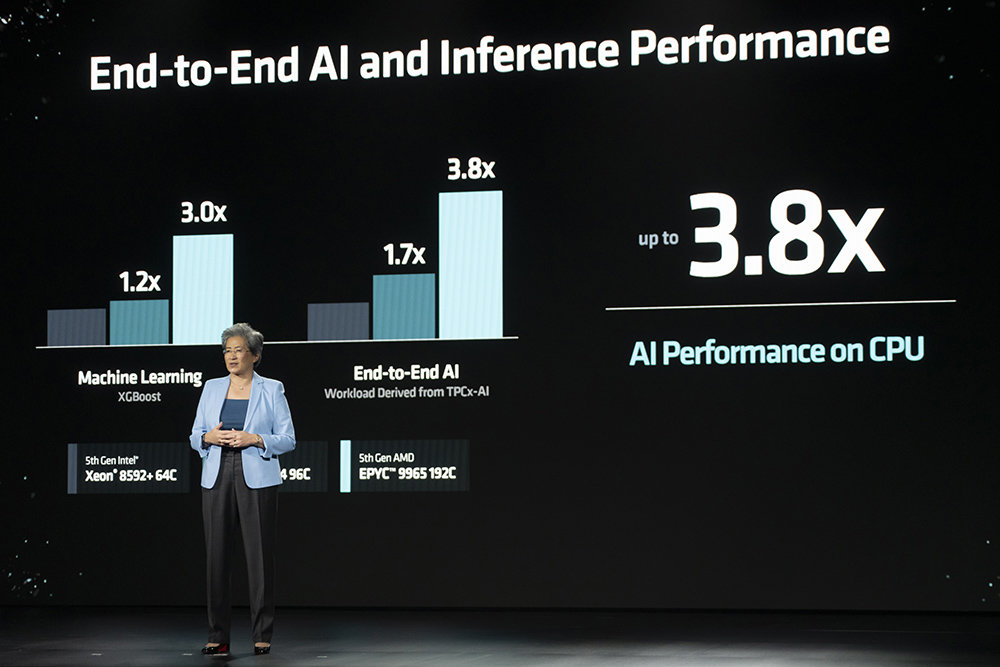

성능 측면에서는 사이클당 명령어 처리 횟수가 기업용 클라우드 환경에서 최대 17% 향상됐고, 고성능 컴퓨팅 및 AI 처리는 37% 향상된다. SPECrate_2017_Int_처리속도는 5세대 인텔 코어 8592+ 64코어 모델을 1로 설정할 때, 192코어 에픽 9965 모델이 2.7배 빠르다. 작업 속도도 비디오 전환 속도 4배, 작업용 앱 2.3배, 오픈 소스 데이터베이스 처리 속도 4배, 이미지 렌더링 속도는 3배 늘었다. 시뮬레이션 시각화 속도는 64코어 기준 1.6배, 고성능 컴퓨팅 환경에서 모델링 및 시뮬레이션 처리는 3.9배까지 빨라졌다.

AI 처리 성능 면에서는 5세대 인텔 8592+와 비교해 XG부스트 머신러닝 속도는 3배, 엔드투엔드 AI 성능 및 유사성 검색은 3.8배, LLM 성능은 1.9배 늘었다. 인스팅스 MI300을 최대로 연결했을 때 인텔 8592+ 대비 추론 성능은 8%, 학습 성능은 20% 더 늘어난다. 엔비디아 H100과 연결 시에는 GPU 추론 성능은 20%, 학습 성능은 15% 앞선다.

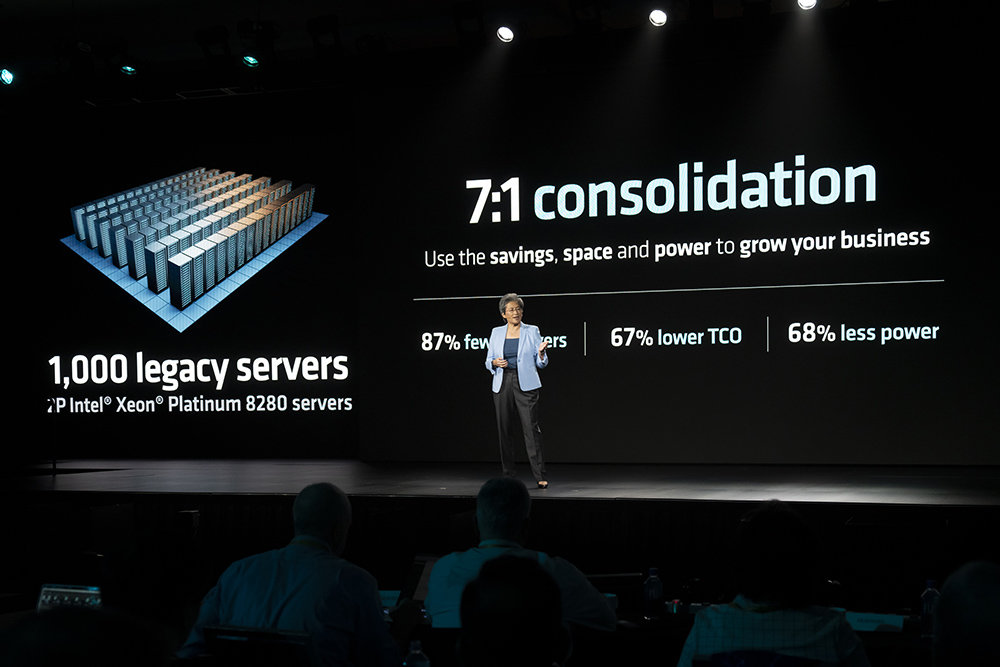

공간 및 효율 측면에서는 인텔 제온 플래티넘 8280 1000개로 구성된 서버를 에픽 9965 131개만으로 대체할 수 있으며, 이때 공간 효율은 7배 정도 줄어든다. 소비전력도 68% 줄어들고, 3년 간 총 소유비용도 67% 줄인다. 가격은 8코어 제품인 9015가 최소 527달러(70만 원대)부터 시작하며, 128코어 9755가 1만 2984달러(약 1745만 원), 젠5C 아키텍처 기반의 192코어 9965가 1만 4813달러(약 1990만 원)로 설정된다.

AI PRO 300 시리즈, 네트워크 프로그래밍 지원 DPU도 출시

AMD의 기업용 프로세서인 라이젠 프로 제품군도 AI 300 시리즈과 마찬가지로 리브랜딩 됐다. 새로운 라이젠 AI 프로 300 시리즈는 마이크로소프트 코파일럿을 지원하며, RDNA 3.5 기반의 16개 GPU 코어와 2세대 XDNA NPU를 탑재해 최대 55TOPS(초당 55조 회 연산) 성능을 낸다. 프로세서 구성은 라이젠 AI 9 HX PRO 375 및 370이 12코어 24스레드, 라이젠 AI 7 프로 360이 8코어 16스레드다.

AMD는 데이터서버의 프론트앤드용으로 AMD 펜산도 셀리나 DPU를, 백엔드 환경에서는 업계 최초로 울트라 이더넷 컨소시엄(UEC) 규격을 지원하는 AMD 펜산도 폴라라 400 네트워킹 인터페이스 카드(NIC)를 각각 출시한다. 셀리나 DPU는 이전 세대에 비해 2배 성능 및 대역폭을 제공하며, 최대 400GB의 처리량을 지원한다. 두 제품은 모두 샘플링 단계에 있고, 올해 4분기 중 고객을 확보한 뒤 내년 상반기에 출시된다.

올해로 재임 10년 차 맞은 리사 수, AI로 새로운 도약 간다

리사 수 AMD 최고경영자는 지난 9월 열린 골드만삭스 커뮤나코피아 & 테크놀로지 콘퍼런스에서 “AMD는 1년 주기로 AI 로드맵을 가속화하고 있다”라며, “AI 슈퍼사이클은 이제 시작”이라고 말한 바 있다. 이번에 출시된 AMD 인스팅트 MI325는 앞서 밝힌 제품 로드맵에 맞춰 출시된 첫 제품이며, 이에 대한 시장의 기대는 상당하다.

지난 7월 열린 2분기 실적 발표에서 리사 수 최고경영자는 “AI칩에 대한 수요가 급증해 올해 매출 예상치를 40억 달러에서 45억 달러로 상향했다”라고 말했고, 2분기 매출과 순이익 모두 전년 대비 9%, 19%씩 증가했다. 특히나 경쟁사인 엔비디아가 차세대 칩인 ‘블랙웰’ 출시를 약 3개월가량 늦춘 상황에서, AMD 인스팅트 MI325X는 예정대로 출시돼 AMD가 AI 시장의 수요를 조금 더 먼저 받아낼 수 있게 됐다.

리사 수 AMD 최고경영자는 “이번 주가 AMD에서 일한 지 10주년이 되는 해다. 우리의 일은 너무나 중요하고, 이 산업에 함께하게 된 점은 행운이라 생각한다. AMD는 고성능 컴퓨팅과 AI의 한계를 계속 넓히고 있다. 이것은 이제 시작이다”라고 덧붙였다.

IT동아 남시현 기자 (sh@itdonga.com)

-

- 좋아요

- 1개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

댓글 0